Analyse von RKI Coronadaten

Am Beispiel der Coronadaten des RKI (Robert-Koch Institut) möchte ich den Einsatz von analytischen Datenbanken (OLAP) zeigen. Mit ihnen ist es möglich Datenbestände aus verschiedenen „Richtungen“ zu betrachten, Kennzahlen zu bilden und Verteilungen zu ermitteln. Technisch werden die Daten mit der Datei RKI_COVID19.CSV zur Verfügung gestellt.

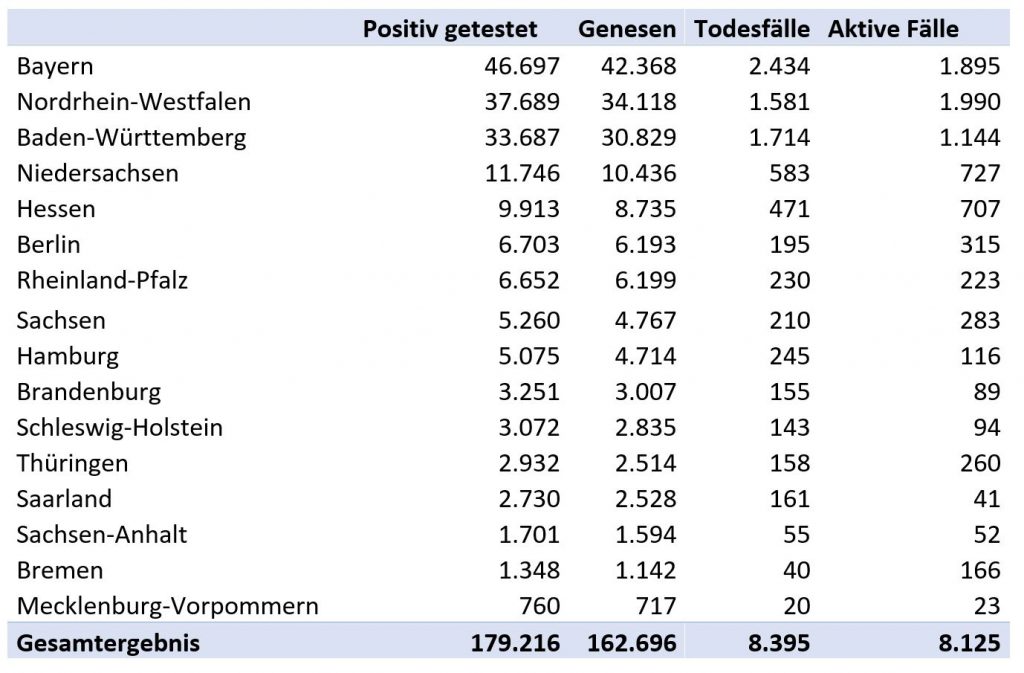

Der (fast) täglich bereitgestellte Datensatz umfasst die nach Region, Geschlecht, Alter und Datum getrennten Zahlen für Positiv getestete, Todesfälle und Genesende. Als abgeleitete Größe bleiben die aktiven Fälle. Für den 28.5.2020 ergibt sich nach Bundesländern aufgeschlüsselt folgende Situation:

Innerhalb der Bundesländer erlaubt die Hierarchie die Betrachtung einzelner Regionen (Kreise etc.). Hier ein Beispiel:

Innerhalb der Bundesländer erlaubt die Hierarchie die Betrachtung einzelner Regionen (Kreise etc.). Hier ein Beispiel:

Die 10 am stärksten betroffenen Regionen (Anzahl der Positiv Getesteten mit Stand vom 28.5.2020) sind:

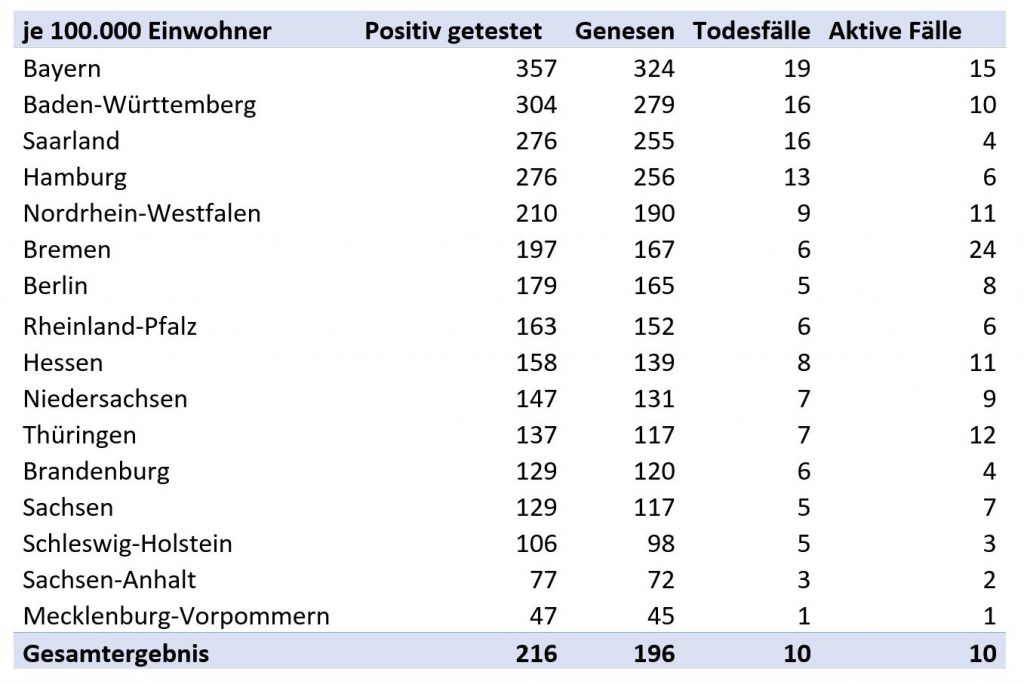

Um die Daten miteinander vergleichbar zu machen, werden sie auf jeweils 100.000 Einwohner bezogen. Am stärksten betroffen sind Bayern, Baden-Württemberg, und das Saarland.

Um die Daten miteinander vergleichbar zu machen, werden sie auf jeweils 100.000 Einwohner bezogen. Am stärksten betroffen sind Bayern, Baden-Württemberg, und das Saarland.

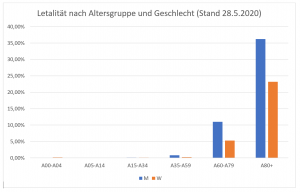

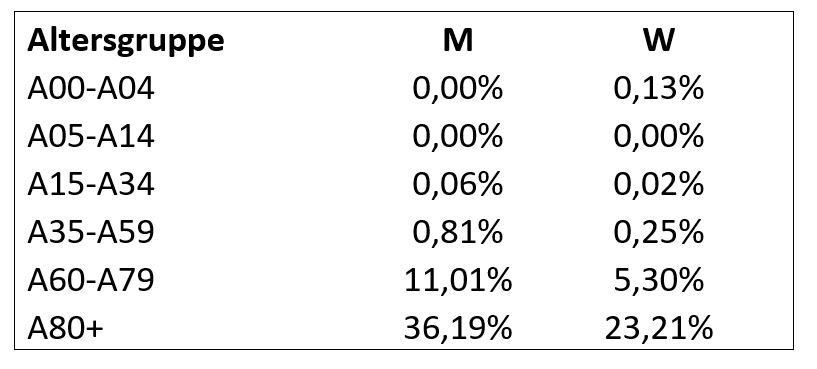

Eine andere Betrachtungsrichtung gibt den Blick auf die Altersgruppe. Auffällig dabei ist die Häufung der Todesfälle in den höheren Altersklassen. Betrachtet man die Letalität (Rate der Todesfälle der infizierten) ergibt sich eine deutliche Zunahme mit höherem Alter und ein unterschiedliches Verhalten zwischen männlichen und weiblichen Erkrankten.

Eine andere Betrachtungsrichtung gibt den Blick auf die Altersgruppe. Auffällig dabei ist die Häufung der Todesfälle in den höheren Altersklassen. Betrachtet man die Letalität (Rate der Todesfälle der infizierten) ergibt sich eine deutliche Zunahme mit höherem Alter und ein unterschiedliches Verhalten zwischen männlichen und weiblichen Erkrankten.

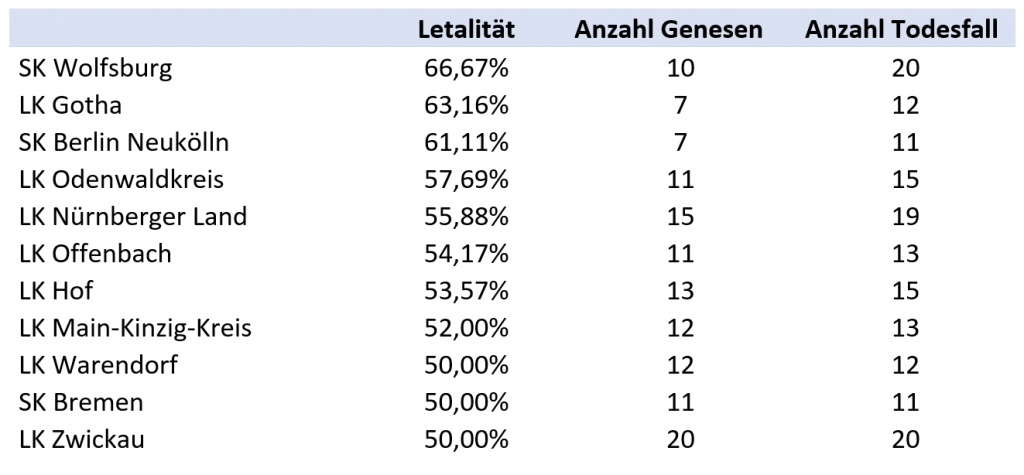

Die höchste Letalität von über einem Drittel (weist die Gruppe der männlichen Erkrankten in der höchsten Altersgruppe (80+) auf. Regional zeigen sich auch hier starke Unterschiede:

Im nächsten Blog geht es weiter mit der Betrachtung der Entwicklung Zeitablauf und Verteilungsrechnungen.

Anomalien finden: „Einer ist anders“

Häufig besteht die Aufgabe eines Sachverständigen darin, Hinweise auf Anomalien zu finden. Datenbestände, die eigentlich weitgehend homogen sein müssten sind auf Ausreißer zu untersuchen. Leider sind diese erst einmal nicht so gut zu erkennen wie die sprichwörtlichen schwarzen Schafe in einer Herde von Tieren mit hellem Fell.

Ein Weg dazu ist die Verteilungsanalyse in Kombination mit einer Visualisierung der Ergebnisse. Durch die 1-2-5 Transformation mit anschließender grafischer Darstellung wird der Ausreißer sofort sichtbar. Im folgenden Beispiel handelt es sich von Antwortzeiten verschiedener Datenbankanwendungen. Es wird sofort deutlich, welche der Anwendungen einmal genauer untersucht werden muss.

Dieser Ansatz lässt sich global einsetzen, etwa bei der Umsatz-/Absatzanalyse, Störungen, Reklamationen usw.

Kontakt aufnehmen …

Strukturanalyse

Die Zeitpunkt-bezogene Analyse gibt bereits einen guten Eindruck von der Struktur des Untersuchungsobjektes und kann schon erste Auffälligkeiten zeigen. Eine wesentlich größere Aussagekraft hat die Analyse im Zeitablauf. In einem Sachverständigengutachten wird damit visualisiert, ob und in welchem Umfang Strukturänderungen oder -Brüche vorliegen.

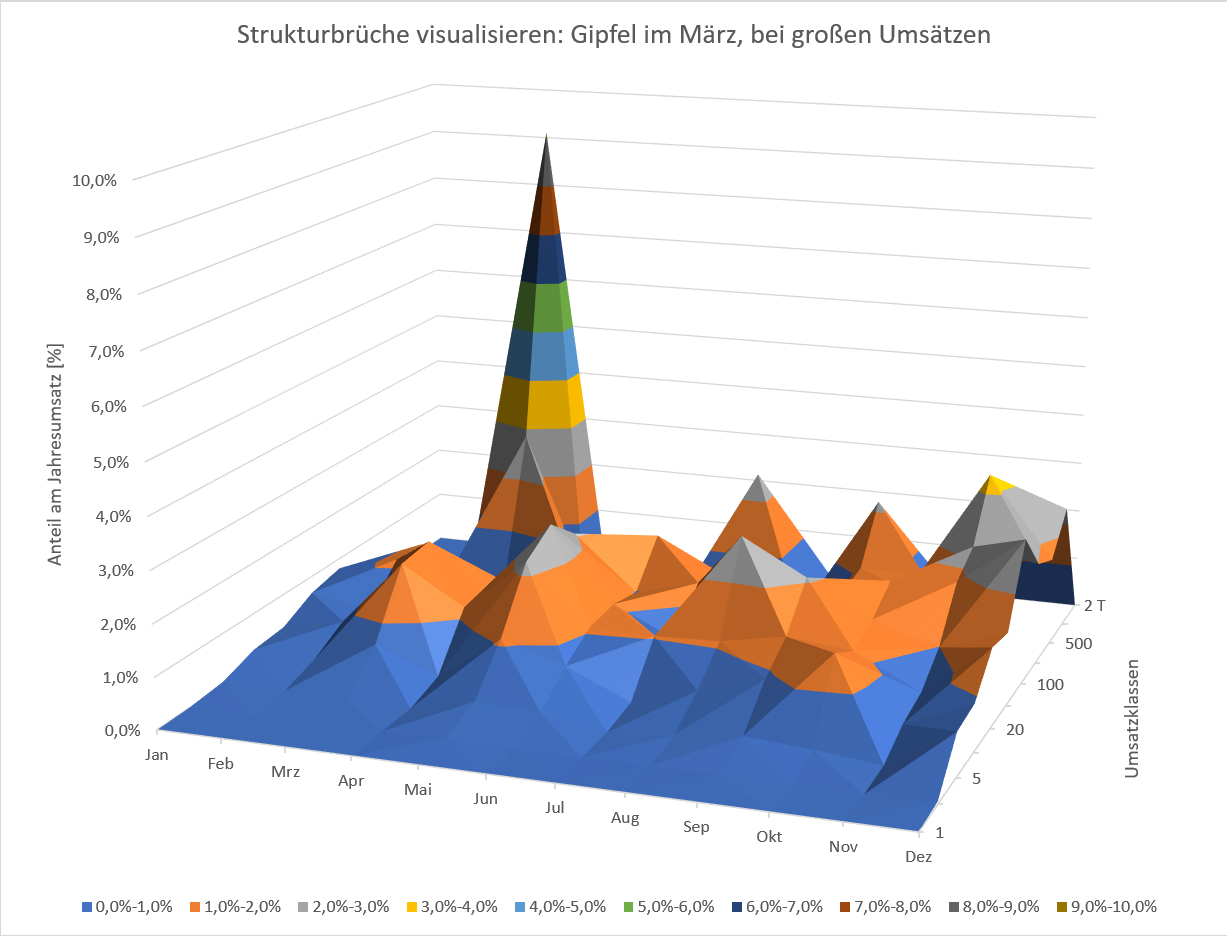

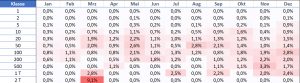

Ein Beispiel aus einer Umsatzanalyse soll dies zeigen. Basis ist die Darstellung nach dem Businesslog (1-2-5), bei dem die einzelnen Umsätze den Größenklassen (1-2-5-10-20-50-100 etc.) zugeordnet werden. Als Erweiterung wird hier nun die Zeit als weitere Dimension mit dazu genommen (hier Jan-Dez).

Erwartungsgemäß sehen wir einen Anstieg der Umsätze im November und Dezember (Jahresendgeschäft). Ansonsten ist das Geschäft geprägt von Umsätzen in mittleren Klassen.

Auffällig ist ein Gipfel im März in der Umsatzklasse von 2.000 €. Hier werden gut 9% des Jahresumsatzes realisiert; ähnliche Gipfel finden sich sonst nirgends im Datenbestand, sodass hier eine weitere Untersuchung angesetzt werden muss. (Im vorliegenden Fall stellte sich heraus, dass die Daten hier manipuliert worden waren).

Kontakt aufnehmen …

RFM-Analyse: Strukturen erkennen

Die RFM-Analyse ist wahrscheinlich der bekannteste mehrdimensionale Analyseansatz. Ursprünglich für das Marketing entwickelt lässt sie sich in Sachverständigengutachten effektiv nutzen.

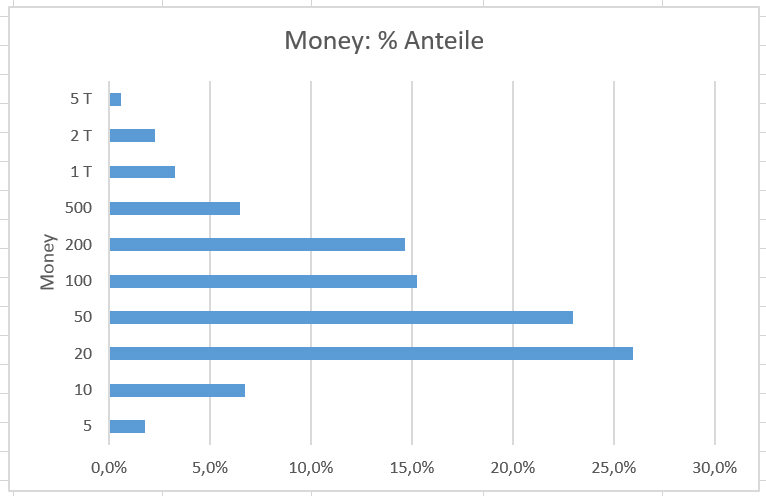

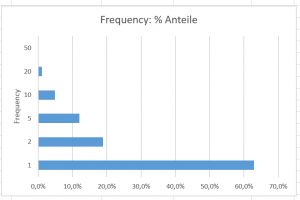

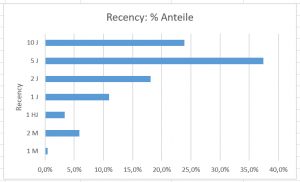

Die Abkürzung RFM steht für Recency (Zeitraum seit dem letzten Event), Frequency als Häufigkeit der Vorkommnisse und Money für die bewertete Größe.

Ein Beispiel soll das verdeutlichen: eine RFM Kunden Umsatzanalyse zeigt für jeden Kunden den Zeitraum seit dem letzten Umsatz, die Anzahl der Rechnungen in den letzten Jahren und den Gesamtumsatz in diesem Zeitraum.

Technisch lässt sich die RFM-Analyse effektiv umsetzen. Nach der Verdichtung der Kundenumsätze in (logarithmisch orientierte) Klassen erfolgt über eine Clusteranalyse eine Gruppenbildung. Diese zeigt nun die vorliegenden Strukturen im Kundenstamm.

Als Erweiterung kann man den einzelnen Gruppen (Clustern) Erwartungswerte für zukünftige Umsätze zuordnen und hat so die Grundlage für die Bewertung des Kundenstamms. Neben diesen betriebswirtschaftlichen Anwendungen lässt sich der Ansatz einfach auf technische Gebiete wie Störungs- oder Reparaturanalyse übertragen.

Kontakt aufnehmen …

Verfälschung von Datenbeständen: Erste Maßnahmen

Ein zunehmender Anteil von Datenbeständen wird manipuliert. In der Regel geschieht dies vor dem Hintergrund wirtschaftlicher Interessen oder um eine andere Straftat zu verdecken. Häufig kann man bereits mit einer Kombination effizienter Verfahren Hinweise auf das Vorliegen von Manipulationen bekommen. Diese ersten Tests würde man in der Medizin das „kleine Blutbild“ nennen.

Es umfasst folgende Komponenten:

-

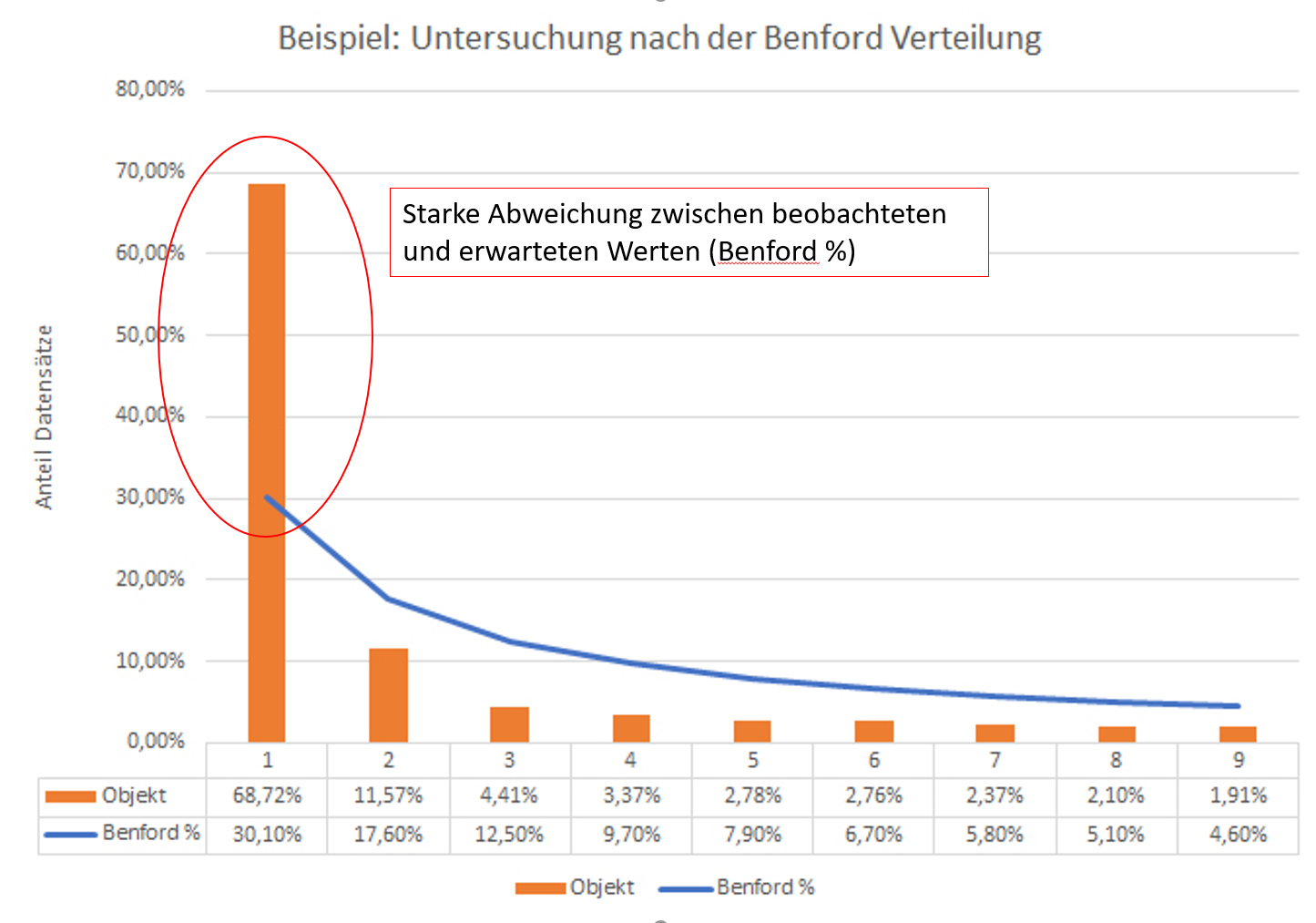

Ziffernanalyse nach den Benfordschen Gesetz

Der Physiker Frank Benford hat vor etwa 100 Jahren herausgefunden, dass in unverfälschten Datenbeständen die Häufigkeit des Auftretens der ersten Ziffer einer festen Verteilung folgt. Ein Verstoß gegen diese Verteilung kann bereits ein erster Hinweis auf eine Datenverfälschung sein.

-

Verteilungsanalyse

kaufmännische Daten wie etwa Umsätze sind in der Regel logarithmisch normalverteilt. Es lässt sich leicht überprüfen ob ein Datenbestand dieser Verteilung genügt.

-

Strukturänderungen im Zeitablauf

bei dem Verdacht auf Manipulation werden die Ergebnisse aus einem „unverdächtigen“ Zeitraum mit dem Untersuchungszeitraum verglichen. Bei signifikanten Veränderungen, ohne dass ein inhaltlicher Grund erkennbar ist wie etwa die Änderung im Geschäftsmodell kann dies ein starker Hinweis auf Verfälschungen sein.

Im nächsten Schritt würde dann gegebenenfalls die tiefgreifende forensische Datenanalyse (Fraud Detection) begonnen.