RFM-Analyse: Strukturen erkennen

Die RFM-Analyse ist wahrscheinlich der bekannteste mehrdimensionale Analyseansatz. Ursprünglich für das Marketing entwickelt lässt sie sich in Sachverständigengutachten effektiv nutzen.

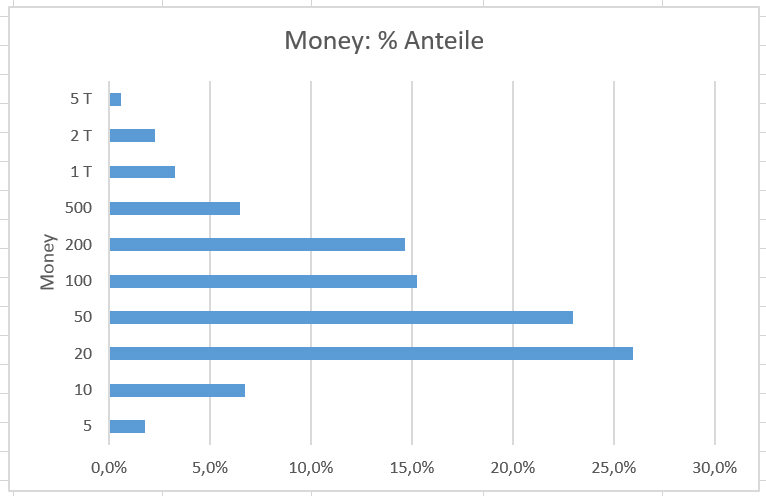

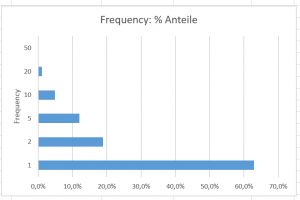

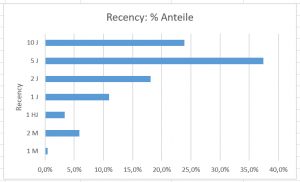

Die Abkürzung RFM steht für Recency (Zeitraum seit dem letzten Event), Frequency als Häufigkeit der Vorkommnisse und Money für die bewertete Größe.

Ein Beispiel soll das verdeutlichen: eine RFM Kunden Umsatzanalyse zeigt für jeden Kunden den Zeitraum seit dem letzten Umsatz, die Anzahl der Rechnungen in den letzten Jahren und den Gesamtumsatz in diesem Zeitraum.

Technisch lässt sich die RFM-Analyse effektiv umsetzen. Nach der Verdichtung der Kundenumsätze in (logarithmisch orientierte) Klassen erfolgt über eine Clusteranalyse eine Gruppenbildung. Diese zeigt nun die vorliegenden Strukturen im Kundenstamm.

Als Erweiterung kann man den einzelnen Gruppen (Clustern) Erwartungswerte für zukünftige Umsätze zuordnen und hat so die Grundlage für die Bewertung des Kundenstamms. Neben diesen betriebswirtschaftlichen Anwendungen lässt sich der Ansatz einfach auf technische Gebiete wie Störungs- oder Reparaturanalyse übertragen.

Kontakt aufnehmen …

Verfälschung von Datenbeständen: Erste Maßnahmen

Ein zunehmender Anteil von Datenbeständen wird manipuliert. In der Regel geschieht dies vor dem Hintergrund wirtschaftlicher Interessen oder um eine andere Straftat zu verdecken. Häufig kann man bereits mit einer Kombination effizienter Verfahren Hinweise auf das Vorliegen von Manipulationen bekommen. Diese ersten Tests würde man in der Medizin das „kleine Blutbild“ nennen.

Es umfasst folgende Komponenten:

-

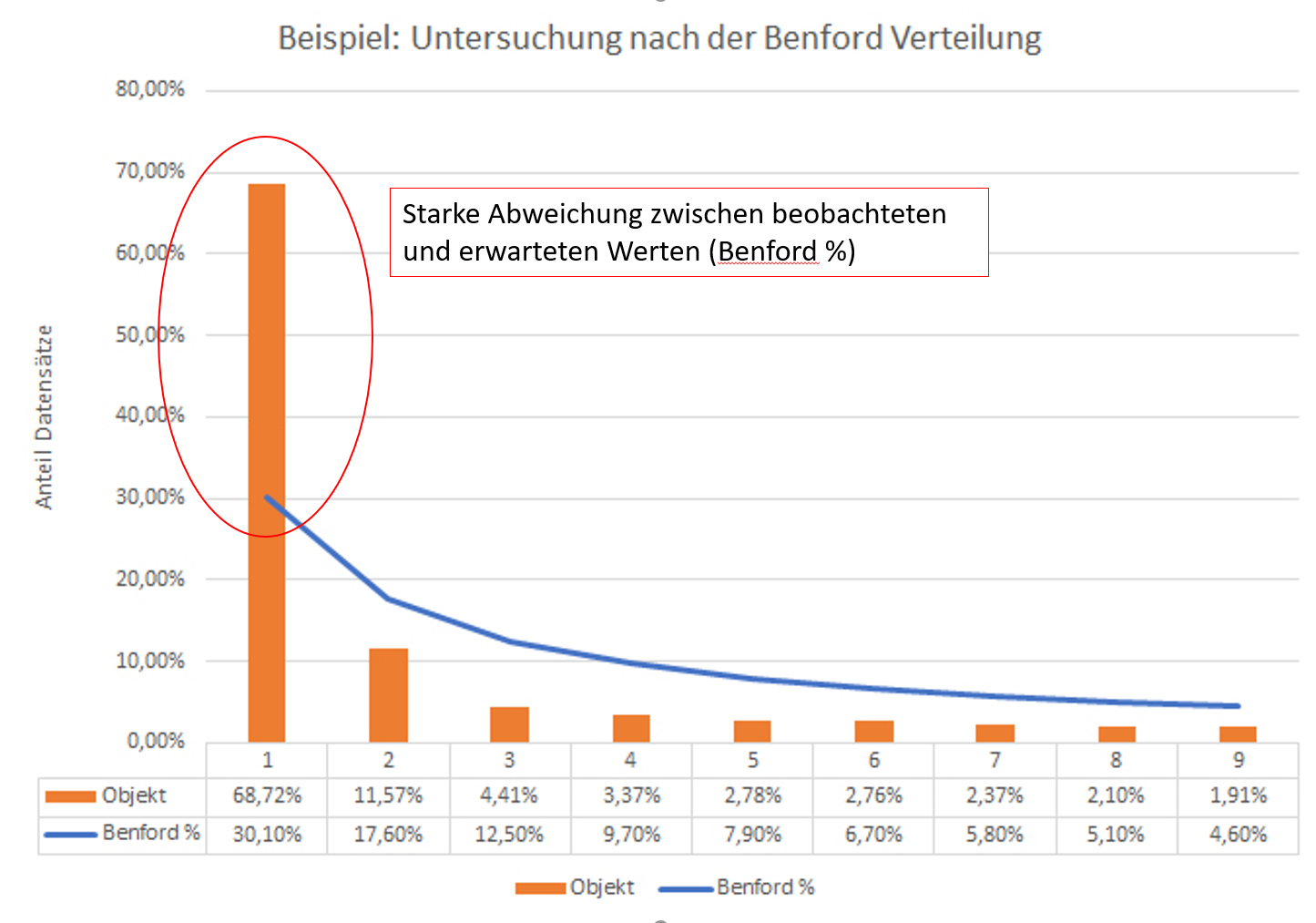

Ziffernanalyse nach den Benfordschen Gesetz

Der Physiker Frank Benford hat vor etwa 100 Jahren herausgefunden, dass in unverfälschten Datenbeständen die Häufigkeit des Auftretens der ersten Ziffer einer festen Verteilung folgt. Ein Verstoß gegen diese Verteilung kann bereits ein erster Hinweis auf eine Datenverfälschung sein.

-

Verteilungsanalyse

kaufmännische Daten wie etwa Umsätze sind in der Regel logarithmisch normalverteilt. Es lässt sich leicht überprüfen ob ein Datenbestand dieser Verteilung genügt.

-

Strukturänderungen im Zeitablauf

bei dem Verdacht auf Manipulation werden die Ergebnisse aus einem „unverdächtigen“ Zeitraum mit dem Untersuchungszeitraum verglichen. Bei signifikanten Veränderungen, ohne dass ein inhaltlicher Grund erkennbar ist wie etwa die Änderung im Geschäftsmodell kann dies ein starker Hinweis auf Verfälschungen sein.

Im nächsten Schritt würde dann gegebenenfalls die tiefgreifende forensische Datenanalyse (Fraud Detection) begonnen.